不忘初心 牢记使命

网络强国 科技创新

“大模型发展过程中,实现大模型的核心基础技术并未见颠覆性的创新,而是通过长期迭代演进逐步发展到目前水平。”近日,北京航空航天大学计算机系主任肖利民教授在采访中表示,通过“大算力+大模型+大数据”的高效组合,AI大模型逐步解决了需要大量标注样本、跨领域自适应能力、多任务泛化能力等传统AI落地难的问题,使得通用人工智能(AGI)实质性落地应用成为可能。

谈及AI大模型的关键技术,肖利民说,以GPT为代表的大模型,通过基于Transformer结构的模型叠加和并行化,面向海量非标注数据的自监督学习、多任务学习/元学习/迁移学习,基于人类反馈的强化学习,基于跨媒体对齐的多模态翻译和转换等大模型核心创新技术的持续融合演进,使得大模型在跨领域多任务中表现出的智能化水平有了质的变化。

大模型的发展和应用将赋能千行百业,为实体经济中的企业提供更加智能化的技术和工具,促进各行业和领域的创新发展,推动新产品、新服务、新业态的出现。肖利民表示,一方面,大模型可利用大量的数据进行分析和预测,帮助实体经济中的企业做出更准确的决策。例如,通过对市场趋势、消费者行为、供应链等的分析和预测,企业可精准了解市场需求、更好优化产品和服务,提高运营效率和竞争力。另一方面,大模型可用于自动化和智能化系统,助力实体经济中的企业提高生产效率和质量。例如,在制造业中,大模型可用于质量控制、设备运维、供应链优化等复杂任务,实现智能化生产和运营。

入局大模型研发的门槛有多高,需要怎样的算力支持?大模型的研发和构建在模型训练、大数据收集、大数据清洗、核心技术研发及关键人才招揽等诸多方面都需要付出高昂的代价。肖利民表示,大模型训练需要有高算力、大内存、高互联带宽、高运行效率的智能计算平台。以GPT 3.0为例,其模型参数总量达1750亿个,训练样本Tokens数达3000亿个,计算量高达314ZFLOPS,最大数据集45TB,参数和模型状态存储量超过2.1TB,如果要求训练在30天内完成,以A100芯片为例,训练阶段至少需要1558块A100GPU,耗费至少2337万美元。

未来,不仅要关注大模型的研发和构建,更要注重大模型的精调和使用,以发挥大模型的实际效用。产业界越发关注大模型,但大模型并非多多益善,其研发、训练需要持续的算力、人才投入,通常只有大型龙头企业或领军企业才能负担得起。基于通用大模型,聚焦场景需求解决实际问题,打造精耕细作的行业大模型,打通AI应用的“最后一公里”,才能更好赋能实体经济发展。(记者 吴双)

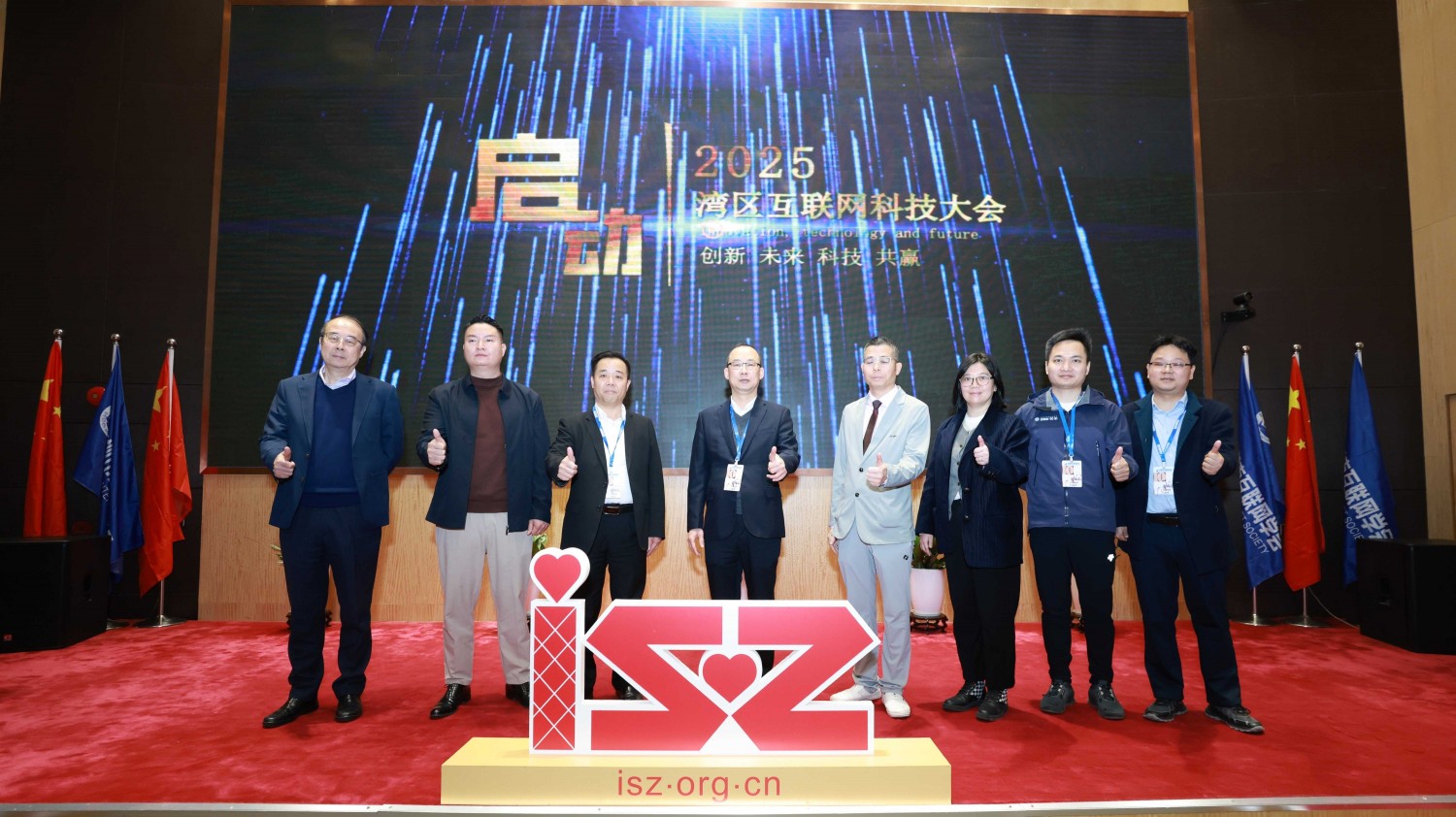

2025中国互联网科技大会暨中国人工智能应用发展大会/中国AI节在北京隆重举行启动仪...

2025深圳市互联网学会春茗座谈会在厉害猫举行,2025年工作规划。将坚持“一周一走...

咨询热线

地址:深圳市龙岗区坂田街道坂田国际中心E栋二层209房

扫码加客服微信

扫码加客服微信 关注微信公众号

关注微信公众号 备案号:粤ICP备14018046号

备案号:粤ICP备14018046号