不忘初心 牢记使命

网络强国 科技创新

姬广绪| 文

正如电子前线基金会的克里斯·帕莫所说,“你获得的是免费服务,你付出的是个人信息,而Google和Facebook很懂得如何将个人信息兑换成金钱。”

如果说获取免费服务的代价仅仅是将个人信息用于商业性的广告定制和更加精准地推送给客户,那其实也还好。但是随着算法的不断迭代,个人的信息搜集变得越来越普遍时,我们发现这种“个性化”左右的不仅仅是我们购买何种商品和服务。

随着移动互联网的发展及智能终端的普及,越来越多人的主要新闻和信息来源依赖于网络新闻资讯平台,从目前的趋势来看,以今日头条为代表的互联网新闻平台将是中国公众未来主要的信息来源。在今日头条这样的平台上,表面上,“你所关心的就是头条”,平台在迎合你的兴趣爱好,给你推送“个性化定制”新闻。实际上,你能看见什么由平台的算法所决定,算法在影响你的立场,进而塑造你的价值观。

目前多数的算法和信息过滤技术,都是根据用户的点击内容、文字输入和搜索等动态行为来判断你可能会感兴趣的内容。用户在网上的行为会被详细记录、标签,以此来推断你的好恶。只看想看的信息,听起来是一件很愉快的事情,但长此以往,你就被隔离在信息的孤岛上,丧失了理智选择的权利。

在今天的互联网上,所有的平台和网站都不会告诉用户其搜索到或被推送的信息是如何遴选出来的,用户同样不知道,算法在背后已经对自己进行了全方位的立体画像。

帕斯奎尔将由于算法的秘密性所带来的信息社会称为“黑箱社会”,并且新媒体们可以逃避责任,不必像传统媒体那样直面公众,所有公司都在最大化地隐藏算法设计方法,甚至隐藏算法的存在,“商业机密”成为隐藏的“合理”说辞。因此,索罗斯所声称的,“威权国家可能与拥有大量数据的公司结成联盟,最终形成一个连奥威尔都未曾想象到的极权控制网络”,并非是一个耄耋老人的呓语。

算法囚笼

关于算法的原理,Facebook借助的是EdgeRank,以这种演算法来整理预设的账号首页,亦即头条动态消息。EdgeRank的作用是为Facebook上的每一种互动排名,演算法很复杂,但基本概念相当简单,依据三种因素来计算:第一种因素是亲近度,你在某人的账号上逗留时间越长,表示你和这人的亲近度越大,Facebook越有可能对你发布这人的近况;第二种因素是资讯类型的比重,以“感情状态”为例,加权的比重非常高,因为大家都想知道谁正在和谁交往;第三种因素是时间,近期张贴的事项比旧事重要。

文化认知结构作用:人脑的认知一方面要强化既有的认知,另一方面要获取新知,而人脑每天接触到大量的信息,如何过滤掉无意义的信号,筛选出极小比率的重要资讯,以达到强化既有认知和求取新知的平衡,这一点尤为重要。

在人脑中,这个最重要的机制就是压缩资料。大脑通过压缩信息量,捕捉所见所闻中的精髓概念,在认知人类学中被称为“认知结构”。认知结构的作用就是,一种事物如果反复出现,人脑就没有必要去重新认识。人一旦认出椅子的长相,就知道它的用途。认知结构一旦生成,我们本能上就会去强化这些结构。心理学称这种倾向为“确认偏误”,也就是人们更加愿意相信能够佐证既有观点的事物,往往只看到他们想看的东西。

个人化的文化认知结果会以三种方式阻碍文化多样性认识:第一,过滤罩以人为的方式限制“异文化视野”;第二,过滤罩里的信息环境缺乏激发理解文化多样性的特质。互联网本是人类接触和了解多样文化的最佳窗口,然而人工智能及算法营造出来的过滤罩环境却将这扇大窗户压缩为一面小镜子;第三,人工智能和算法 “推送”的是(它猜测)你会感兴趣的信息,个人主动搜寻和探索异文化的机会被抑制。

基于算法的信息过滤所提供的对于特定问题的解答是一种人工解答,视域极其有限,但很有效。无论你想解决什么样的问题,它都能够给你提供一个高度关联的信息环境。通常这样的环境都很实用,例如当你搜索“非洲黑人”时,搜索引擎会在下方推荐你可能会感兴趣的相关话题,例如“非洲黑人为什么懒”、“广州非洲黑人治理”、“广州黑人凶”等。当你点击相关话题浏览信息时,算法就会将你的这个动态痕迹记录下来,作为日后推荐更加符合你的阅览偏好的信息的关联数据,但这时你看待问题的视野无形中就会被压缩了。算法过滤带来的最大问题就是它没有“拉远镜头”的功能,使用者容易迷失方向,看不清楚事物的全貌,将自己置身于一座信息孤岛上。

算法过滤的机制依循的是三步骤模式:首先,算法通过动态信息和静态信息认清用户身份与喜好;其次,对用户提供最合宜的信息;最后,把算法改良到恰到好处。简言之,你的身份形塑你使用的媒体,反过来媒体也会形塑你的身份,最后就是个人和媒体高度互嵌。

当个人化的媒介与特定的人的心理机制结合后,我们会发现身份塑造媒体的同时,媒体也在影响个体相信和关心的事物。当你点击一条关于非洲黑人的新闻的链接时,表示你对那链接表现出兴趣,这代表你未来比较可能点击同一主题的文章和新闻,媒体进而暗中怂恿你继续这个主题。个体就这样被困在一个信息的闭环,反复看见的都是自己想看的信息,陷入传播学中经常提到的“信息茧房”。

例如,浏览网上关于非洲黑人的负面评论,就会发现网友普遍认为黑人都很懒惰、不遵守规则、在广州一定是会扰乱社会治安。这是因为基于人工智能的算法推荐程序不断把相关信息推送给本来就有误解的读者,他们看到的这些信息又验证了已有偏见和假设,成为“自我应验的预言”。

因此,尽管网上有海量信息,深居算法和过滤罩里的我们却陷入了“信息茧房”。尽管网络本可以解放知识、松绑控制,实际却在逐渐收窄我们的视野,限制我们的机会,而网络权力集中在几个人身上,形成史上仅有的少数霸权。科技的初衷是让人类更能控制日常生活,如今的结果却是剥夺我们的权利。

算法正义

针对上述问题,有几个层面的问题需要思考。

首先,从国家和政府的层面,需要对信息时代的公共领域和资源有全新的认识。随着数字生活的全面开启,公众对于信息的消费需求越发强烈,商业性的力量先于政府介入其中并开始控制信息的供给。正常的竞争本无可厚非,既符合商业逻辑,也节约了公共资源。然而商业的逐利本性和垄断操纵野心让公共信息的供给走向歧途,甚至某些巨头企业为了满足投资者的需求开始在搜索引擎中置入非正当、非正义的算法。这就需要政府的主动干预来矫正,合理控制企业在公共信息提供方面的任意性和商业性导向。例如,在承诺保密的前提下,政府可以要求占据垄断地位的巨头企业报备其算法模型,并由自己的专业监管机构或外部专家委员会加以审核。

其次,从企业来说,在保证商业利益的前提下,算法模型应该强调“多元性”,例如瑞士的报纸Neue Zürcher Zeitung(NZZ)最近开发了一款App—— the Companion。像大多数智能新闻终端一样,这款App也通过机器学习生成个人算法,给用户推送个性化的新闻信息流。但与众不同的是,算法会确保这一系列新闻中包含一个“惊喜”,也就是超出读者偏好范围之外的内容。

类似地,谷歌浏览器的“逃离泡沫”(Escape Your Bubble)插件也在做同样的努力,这款插件可以根据用户的阅读习惯,反向推荐调性积极、易于接受的内容。用户每次访问Facebook时,插件会将不同视角的文章自动导入用户的信息流。多元提供了用户逃离“信息舒适区”的可能性,更加多元和丰富的资讯有助于完善今天数字信息的生态。这就要求算法工程师在制作算法的时候应该有意识地通过更加合理的技术增加奇遇、多添一些人性,对微妙的身份差异敏感一些、主动宣传公共议题并培养公民精神,用更加多的“道德算法”解决之前的技术偏见问题。

而作为公共信息的重要来源,头部搜索引擎公司和信息平台公司需要继续强化“信息把关人”的职能,肩负起社会责任、传播人文精神,为用户提供有价值的阅读,真正让重大新闻能看到、有人看,防止算法操控下劣质信息的过度生产和分发。

最后,从用户的角度来说,提升“网络素养”不应仅仅是体现在如何防止网络诈骗,减少经济损失这样直接的利害问题上。提高信息搜索、信息筛选的能力,更是未来融入数字世界的核心所在。良性信息已经成为现代公民重要的生存资源,获取资源能力的关键就在于网络素养的提升,这也是技术赋权的重要方面。

作者为中山大学移民与族群研究中心副研究员、互联网人类学博士,编辑:马克,原载2019年5月27日《财经》杂志

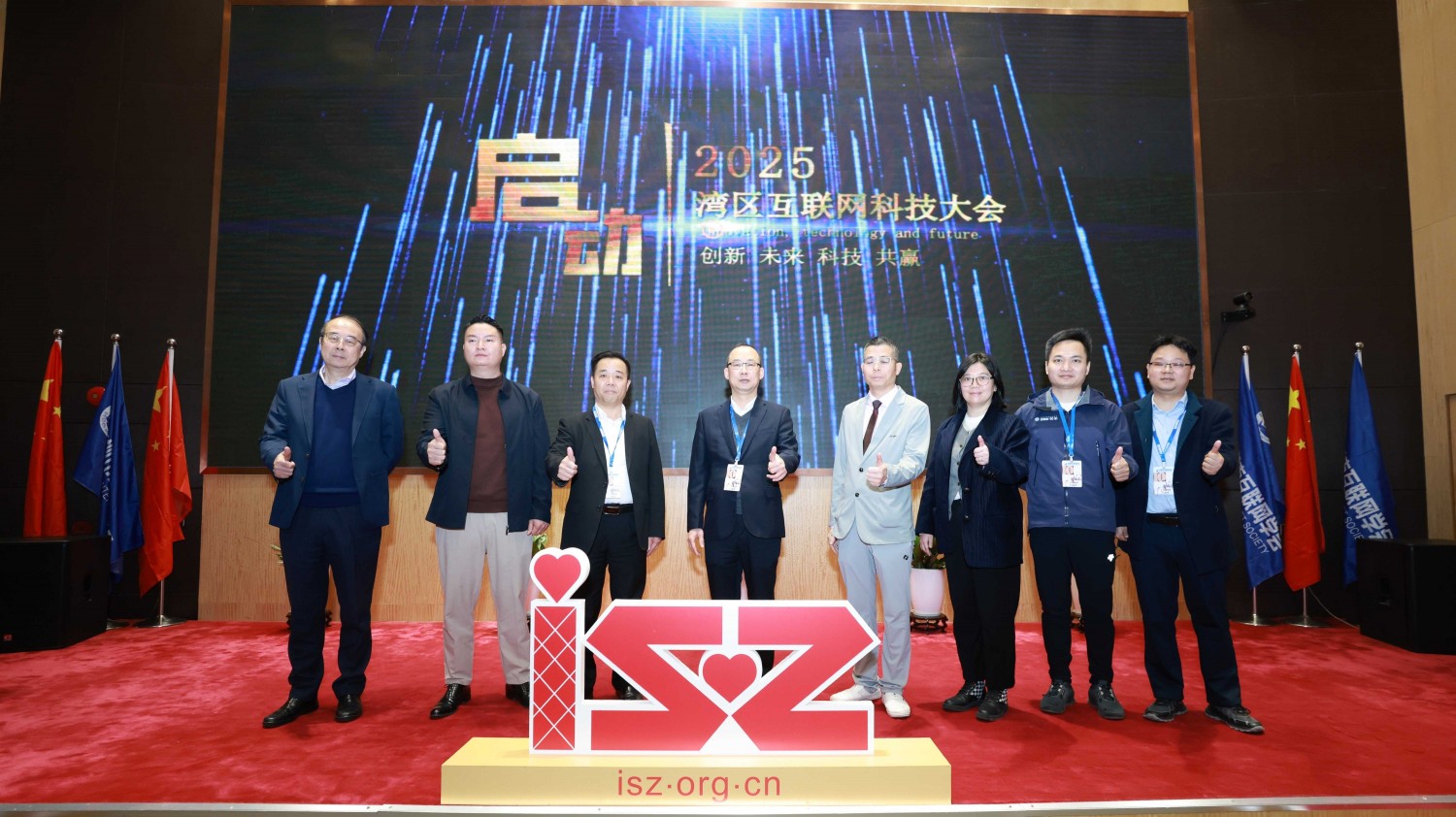

2025中国互联网科技大会暨中国人工智能应用发展大会/中国AI节在北京隆重举行启动仪...

2025深圳市互联网学会春茗座谈会在厉害猫举行,2025年工作规划。将坚持“一周一走...

咨询热线

地址:深圳市龙岗区坂田街道坂田国际中心E栋二层209房

扫码加客服微信

扫码加客服微信 关注微信公众号

关注微信公众号 备案号:粤ICP备14018046号

备案号:粤ICP备14018046号