不忘初心 牢记使命

网络强国 科技创新

具体的做法是:优化现有交互模型+建立新的交互模型

-shenzhenware-

互联网与 AI 的到来,往往伴随着新的技术以及新的产品。但让新产品渗透到人们的生活中并不是件简单的事情,其中,新产品所承载的人机交互体验是否足够好,起到至关重要的作用。

对于产品厂商来说,将一个新兴的人机交互模式从头进行研究和打磨,意味着高成本、长周期的投入,但以他们有限的精力来看,却是力不从心。

但好在有这么一些研究机构愿意全身心投入其中,并积极将研究结果共享出来,推动行业的共同进步。

百度人工智能交互设计院就是这么一个专注研究和探索人机交互应用的机构,于 2017 年 11 月成立,使命是引领与定义最好的人机交互。

在最近由深圳湾主办的「ON THE GO:随行 AI 场景的产品创新」峰会上,百度人工智能交互设计院人机探索实验室负责人李士岩发表主题为《人机交互如何推动硬件周期性变革》的演讲。

以下为演讲实录,内容经深圳湾整理和编辑。

新交互、新产品、新应用存在相辅相成的关系

百度人工智能交互设计院研究方向有三个层次,最底层是「输入」与「输出」,即听觉、视觉、触觉、嗅觉、情感。中层是交互模型,语音、手势、多模态交互。上层则是基于这些交互模型产生的硬件生态和服务生态。

我今天演讲的几个关键词是新交互、新产品、新应用,这三者存在着内在推动关系与周期性规律,人机交互的本质是:基于软硬一体化和传感器的输入反馈循环,人机交互的进化是计算平台迭代的基础,新计算平台的规模化会促进应用生态的繁荣。

从 PC 到智能手机,回顾人机交互的发展历程

在介绍百度人工智能交互设计院的一些研究进展之前,我们先用「从 PC 到智能手机」这样一个典型的发展案例来讲解新交互、新产品、新应用这三者的关系,帮助大家更好的理解。

最早的鼠标于 1968 年秋季联合计算机会议上发布,那时候的鼠标只能移动 XY 轴。

「鼠标之父」格拉斯·恩格尔巴特

而真正形成现代的鼠标交互模型,是由施乐公司在 1981 年发布的 Xerox Star 模型,它具备了目前大家都熟悉的操作:左击-选择、双击-打开、右击-更多。

从 1968 年到 1981 年现代鼠标交互模型的形成,这期间经历了 13 年的时间。而正因为鼠标交互模型形成,从 90 年代到 20 世纪初,PC 硬件生态得到了发展,使得我们产生了基于工作的软件生态,基于在线教育的软件生态,以及基于娱乐的游戏生态。

事实上,早在 1965 年,人机交互历史上就已经有了手指的位置检测技术,而将这种技术真正转化为现在的点击、Pinch、长按的成熟交互模式是在 2007 年。

手指的位置检测技术形成于 1965 年

这种成熟的交互模型,使得众多触摸设备得以被规模化,尤其是智能手机。以手机为主的触摸设备的规模化,直接促进了各种服务生态的繁荣,比如滴滴、餐饮 O2O 等。

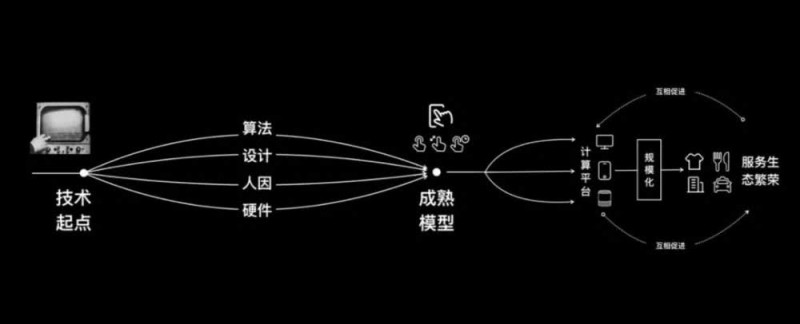

从上帝视角来看人机交互和产品,它的完整历程是:先有一个技术起点,包括算法、设计、人因工程、硬件,接着将这些技术起点打包成一个成熟的交互模型,应用到新的计算平台上。计算平台的发展,进一步促进了衣食住行等服务生态的发展,而服务生态的发展将反过来促进硬件规模化。

我们正处于硬件生态的末端,但 AI 可改变这一切

目前,我们本质上正处于移动硬件生态的末端,不只是因为人口红利的消失,更是因为触摸+传感器所能激发的服务生态走到了尽头,近几年不再看到一个新的服务生态被大规模发展。所以说:

整个硬件的周期始于技术的升级,发展于人机交互的成熟,终结于生态枯竭于规模化的终止。

而 AI 的到来将改变这一切。

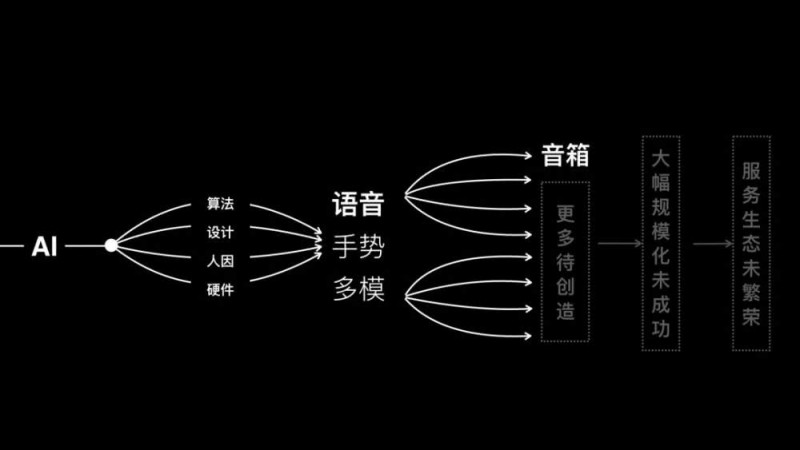

AI 让最底层的输入输出层拥有了听、看和思考的能力,基于 AI 这个技术起点,目前已经形成了语音交互、手势交互、应用各种输入输出层结合形成的多模交互。

由于这种交互模型尚未成熟,智能音箱只是其中一种目前看起来比较有前景的计算平台,但还有更多平台需要被创造,也更谈不上新的计算平台的规模化,服务生态没有达到繁荣。所以我们认为:

目前的当务之急是要将待成熟的人机交互推向成熟。

将待成熟的人机交互推向成熟

要改变这一现状,我认为努力的方向有两个,第一个是优化现有交互模型,提升产品体验。第二个是发展新的交互模型,衍生全新品类。

1. 优化现有交互模型,提升产品体验。

在这方面,百度 AI 人机交互设计院主要把精力花在语音交互的优化上,具体如下:

在语音交互的 5 个节点中:唤醒、响应、输入、理解、反馈,将每一个维度拆分出来不同的维度,进行深入的研究和探索。

# 1.1 语音交互的响应时间是否就越快越好呢?

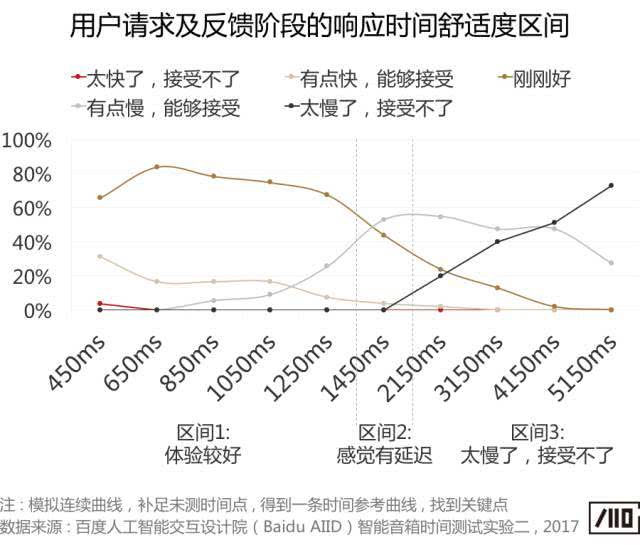

经试验研究发现,语音交互的最佳响应时间是 650ms,底线是 2150s。与触控交互对反馈的要求是越快越好不同,语音交互的响应时间却不是越快越好。

经研究发现,智能音箱对语音指令的响应时间在 1250ms 以内是一个较优的区间,其中 650ms 为最佳体验值,远好于 200ms,过快的响应时间会给用户带来紧迫感。

# 1.2 什么样的唤醒词用户是认为好的呢?

唤醒词为叠字,或阴平、尾音声母为零声母的好。研究表明,用户最不喜欢「品牌+名字」的命名方式,Z/C/S 的舌尖音最不被欢迎。

# 车机屏幕交互、手势操作等人机交互的研究:

其次在车机屏幕交互、手势操作方面,百度 AI 人机交互设计院也进行了大量的研究和探讨。比如,在车载驾驶情况下,用头戴式设备判断用户开车时目光集中分布的部分,从而找到最自然手势操作及对应关系。再比如,从多个手势模型测试中,找到最适合用在「暂停」、「关闭」的手势。

2. 发展新的交互模型,衍生全新品类

#2.1 用户情绪应对模型

在这方面,百度 AI 人机交互设计院研究了用户情绪应对模型,即用户的情感交互模型。

情感是人的刚需,但是却人机交互缺失的一个维度。人机交互发展的几十年来,机器的 IQ 得到发生,但 EQ 没有得到提升。而实际表明,两个 IQ 差不多的产品,EQ 更高的那个产品一定更受欢迎。由此看来,情感交互模型在人机交互中起到重要的作用。

情感交互模型分两个维度,分别为情感识别以及识别情感之后的应对。

情感识别方面,基于东方人的情绪面部数据并进行训练,百度 AI 人机交互设计院打造了适合东方人的情感识别系统。

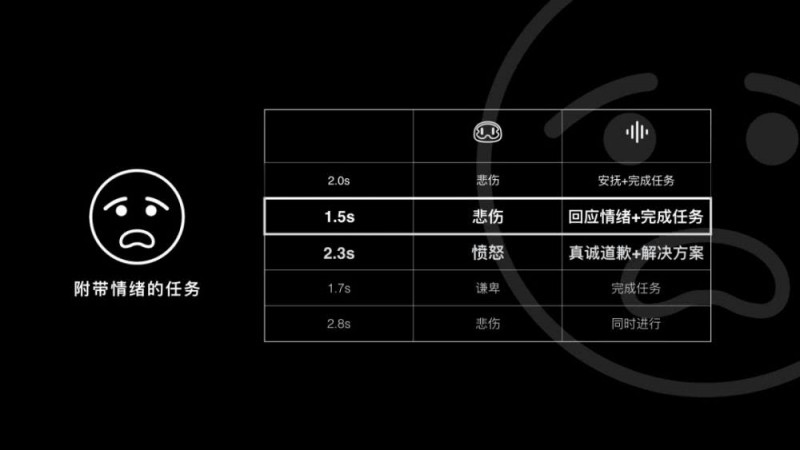

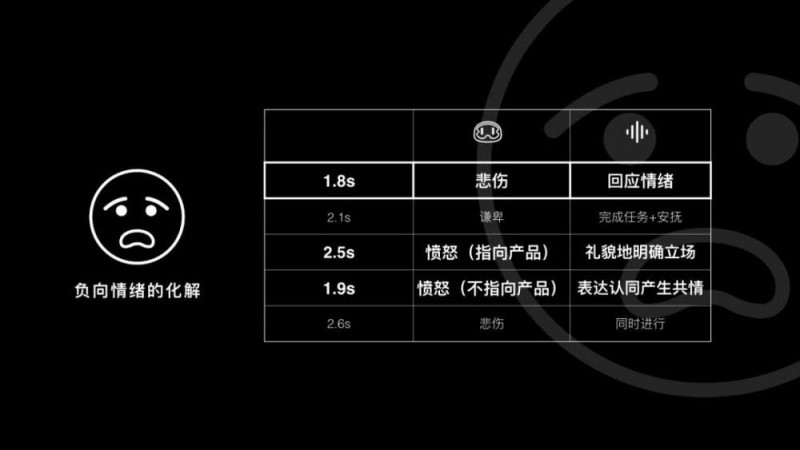

至于识别情感之后的应对,我们将模式场景分为两种,第一种是附带情绪的任务,第二种单纯负向情绪的化解。

在实验室中,我们用不同的应对策略看用户的脑电曲线。比如,在附带情绪的任务中,当用户用悲伤的情绪说一个任务,最好的策略是先用几句话回应情绪再说解决方案,当用户愤怒的时候,则要直接提供解决的方案。

语音交互还有一些特殊的情况,比如在用户指责产品的时候,语音应给予礼貌的回应,表明自己的立场,而不是谦卑的「跪舔」。

人类有 27 种情感,通过情感识交互模型,我们能够将这 27 种丰富的情感一一赋予机器。

#2.2 更自然语音交互模型

在新的人机交互模型方面,我们研究的第二个维度是更自然的自然语音交互模型。

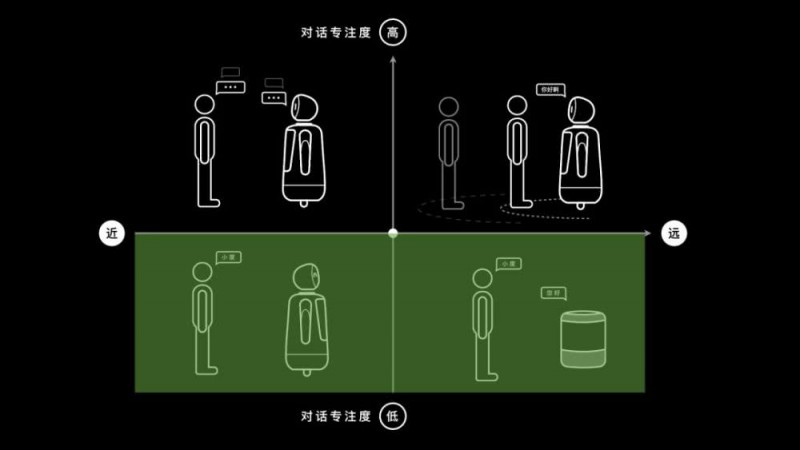

根据用户的专注度和与设备的距离,可以将人机交互分四个象限:低专注距离远和距离近、高专注距离远和距离近。

在我们人和智能音箱交互的过程中,让音箱播放歌曲是属于第三、第四象限的交互范畴(远距离、低专注度),在这个范畴内,也会经常出现为了完成一个连续任务而多次呼唤音箱名字的情况。

其中,第一象限的近场高专注度交互,是目前带屏音箱可以提供的。但针对这一产品品类,目前还缺乏真正有效的交互模型来解决一些交互上的问题。对此,百度 AI 人机交互研究院在过去一年里,研究了名为 Easytalk 的交互模型。

在 Easytalk 的模型中,依托复杂的算法,能在不用麦克风阵列、不用唤醒词的情况下,支持不断打断的语音交互,并且不受其他环境因素影响(比如噪音、其他用户)。基于这个交互模型,每 4 轮对话效率能提升 5%,非 ONE SHOT 主观感受体验提升了 56.2%,ONE SHOT 主观感受体验提升了 31.2%。

我们认为,近场高专注度交互才是未来真正能够带来内容和生态爆发的场景,从人机交互的角度看,带屏智能音箱具备了语音、手势、视觉等更丰富的输入输出能力,既可以满足远场非专注的场景,更可以满足近场、专注的场景,未来有可能真正激发一个繁荣的服务生态。

在未来,这套 Easytalk 模型将被应用在手机、智能音箱、智能机器人上。

尾声

百度 AI 交互设计院人因工程方向和人机探索实验室一面脚踏实地,一面仰望星空。并且,我们有着最专业的设备,专业的 AI 人机交互实验室。

微信号:shenzhenware

整理、编辑:大林/ 深圳湾

审校:森林木/ 深圳湾

2025中国互联网科技大会暨中国人工智能应用发展大会/中国AI节在北京隆重举行启动仪...

2025深圳市互联网学会春茗座谈会在厉害猫举行,2025年工作规划。将坚持“一周一走...

咨询热线

地址:深圳市龙岗区坂田街道坂田国际中心E栋二层209房

扫码加客服微信

扫码加客服微信 关注微信公众号

关注微信公众号 备案号:粤ICP备14018046号

备案号:粤ICP备14018046号